A compté du 15 juin, la nouvelle loi Création et Internet (aussi appelée loi Hadopi) est entrée en vigueur. Une loi qui fit grand bruit avant même son application. Bien que promulguée le 12 mai dernier par l’assemblée nationale, la loi avait fait l’objet d’un recours auprès du Conseil constitutionnel. Le Conseil examina alors le texte et, le 10 juin, y apporta de nombreuses modifications. Mais quelle est la teneur réelle de ce texte ? Pourquoi une polémique s’est-elle construite autour de celui-ci ?

Les origines

La loi Droit d’Auteur et Droits Voisins dans la Société de l’Information (DADVSI), adoptée le 30 juin 2006, prévoyait dans sa version initiale la mise en place d’une « riposte graduée ». Le volet du dispositif prévu prévoyait que le téléchargement réalisé à des fins personnelles ainsi que la communication au public opérée à des fins non commerciales échappaient aux sanctions prévues en cas de contrefaçon pour être considérés comme de simples contraventions. Une solution « douce » qui fut rejetée par le Conseil constitutionnel au nom du principe d’égalité devant la loi pénale.

Toutefois face à l’inefficacité des autres solutions proposées par cette loi et de la difficulté de la mise en place des sanctions (Tout acte de contrefaçon numérique – qui est une atteinte à un droit de propriété – est considéré comme un délit (art. L. 335-2 à L. 335-4 du code de la propriété intellectuelle), passible au maximum d’une peine de 3 ans de prison et de 300 000 euros d’amendes), une mission d’étude fut confié à Denis Olivennes (alors patron de la FNAC) par la ministre de la Culture et de la Communication (Christine Albanel) pour proposer un solution adaptée à la réalité.

Le rapport de Denis Olivennes

Selon le rapport, la méthodologie nécessaire pour parvenir à contrer le piratage via internet doit s’articuler sur deux points principaux :

- désinciter les internautes à télécharger des fichiers illégalement,

- augmenter l’attractivité des offres légales de téléchargement.

Afin de répondre à ses deux points, le rapport établit une liste de suggestions en vue de diminuer le piratage, par exemple :

- diminuer les délais entre la sortie d’un film en salle et la distribution en DVD ou en vidéo à la demande,

- supprimer les dispositifs de protection (DRM) n’offrant pas la possibilité de disposer du fichier quelque soit le matériel utilisé,

- généraliser la TVA réduite sur l’ensemble des produits culturels avec une répercussion intégrale sur le prix public,

- regrouper les ayants droits en un agence unique chargée de la lutte globale contre le piratage,

- généraliser les techniques de filtrage des contenus pirates,

- mettre en place un politique ciblée de poursuites ou un mécanisme d’avertissement et de sanctions…

La loi HADOPI décryptée

La loi HADOPI s’articule principalement autour de la création d’une autorité administrative indépendante H.A.D.O.P.I. (Haute Autorité pour la Diffusion des OEuvres et la Protection des droits sur Internet) autorité publique indépendante chargée de la surveillance des droits d’auteur sur Internet. Elle remplace l’Autorité de Régulation des Mesures Techniques (créée par la loi DADVSI en 2006). Cet organisme devient l’intermédiaire privilégié entre les ayant-droits (AFPA…), chargés de fournir les adresses IP des abonnés suspectés d’avoir manqué à l’obligation de surveillance (il faut comprendre « suspecter de télécharger illégalement ») et le fournisseur d’accès à Internet, chargé d’identifier les abonnés via leur IP.

Les missions d’HADOPI sont :

- d’encourager le développement de l’offre légale par l’intermédiaire notamment d’une labelisation HADOPI (« Ici on télécharge légalement, lol » NDR) pour les sites web de téléchargement licite et la mise en place d’un site de référencement,

- d’observer l’utilisation licite et illicite des oeuvres protégées sur Internet.

Par ailleurs, HADOPI peut être contactée par les ayant-droits afin de faire respecter leurs droits. C’est dans ce cadre que s’applique la fameuse « réponse graduée ». La procédure peut se résumer ainsi :

- l’envoi par mail à l’abonné incriminé d’un premier rappel à la loi,

- l’envoi d’un second rappel par courriel ou lettre recommandée en cas de récidive moins de 6 mois après le premier avertissement,

- la coupure de la ligne en dernier recours (avec obligation pour l’abonné de continuer à payer son abonnement le temps de la coupure).

Dans un premier temps, la coupure pouvait être ordonnée par la Haute Autorité pour la Diffusion des Œuvres et la Protection des droits sur Internet sans même l’intervention de la Justice. Toutefois cette méthode a été invalidée par le Conseil constitutionnel. Désormais seul un juge peut ordonner la coupure sous certaines conditions (voir plus bas).

Comment le Conseil constitutionnel a tué Hadopi…

Le Conseil constitutionnel entra en scène à la fin du mois de mai. En France, le Conseil constitutionnel est le gardien de la Constitution, la norme suprême, supérieure aux lois et aux traités, même européens. La Constitution est une loi adoptée dans des conditions très particulières qui rendent sa modification extrêmement difficile et qui fixe les grands principes de la République (la Constitution inclut ainsi la Déclaration des droits de l’Homme et du citoyen de 1789, pose le principe de l’égalité sans distinction d’origine, de race ou de religion, etc.) et de son fonctionnement (c’est la Constitution qui établit le drapeau, l’hymne national, ainsi que les pouvoirs du président de la République, du Gouvernement, du Parlement, etc…).

Quand une loi est adoptée, elle peut (c’est facultatif, sauf trois exceptions : les lois soumises à référendum, les lois organiques et les règlements des assemblées parlementaires) être déférée au Conseil constitutionnel qui jugera de leur conformité à la Constitution. La décision de déférer une loi au Conseil constitutionnel peut être prise par le président de la République, le président du Sénat, le Président de l’assemblée nationale, ou un groupe de soixante députés ou soixante sénateurs (pas de panachage entre les deux assemblées). Cette décision, appelée recours, doit idéalement être motivée, c’est-à-dire indiquer en quoi cette loi violerait la Constitution.

En étudiant la loi HADOPI, le Conseil rejeta certains griefs exposés (stipulant que concernant ces points, la loi n’allait pas à l’encontre de la Constitution) et entreprit des modifications sur la loi afin de rendre d’autres points conformes.

Avec la loi HADOPI, les bases de données établies par des sociétés privés dans le cadre de la surveillance des réseaux deviendront nominatives, puisque l’identité de l’abonné peut être obtenue facilement auprès du FAI. Le Conseil n’interdit pas la méthode, il rappelle seulement que la Commission Nationale Informatique et Liberté (la CNIL) a pour vocation de surveiller les traitements informatiques de données nominatives, et qu’il lui appartiendra de s’assurer que les modalités de ce traitement sont proportionnées au but poursuivi. En clair, cela signifie que toute poursuite fondée sur ces relevés sera nulle tant que la CNIL n’aura pas donné son feu vert quant au fonctionnement de ce fichier. La CNIL est aussi invitée à veiller à ce que ces données ne servent que dans le cadre des procédures judiciaires liées au piratage supposé et ne soient pas conservées à d’autres fins, genre une liste noire des pirates.

A l’état initial, la loi permettait aux ayant-droits d’une œuvre piratée d’obtenir du FAI qu’il puisse suspendre l’accès internet du pirate supposé. Désormais, HADOPI ne peut plus statuer sur cette suspension. La suspension ne peut être ordonnée que par l’autorité judiciaire, ce qui est une garantie. Mais le Conseil est même allé plus loin, en soufflant à l’oreille du juge le mode d’emploi (il appartiendra à la juridiction saisie de ne prononcer, dans le respect de cette liberté [la liberté d’expression, voir plus bas], que les mesures strictement nécessaires à la préservation des droits en cause). Bref, le juge devra se contenter d’ordonner le strict minimum pour mettre fin à cette atteinte au droit d’auteur sans porter atteinte de manière disproportionnée à la liberté d’expression, qui devient la marraine, comme on va le voir, de l’accès à internet. Autant dire que le seul abonnement qui pourra être suspendu est celui qui ne sert qu’à pirater à l’exclusion de tout blogging, twitting, facebooking, netsurfing…

Durant les débats aux assemblées, les apologistes de la loi n’avaient de répéter qu’il n’y a pas de droit à l’abonnement à Internet et qu’Internet n’est pas un droit fondamental, justifiant ainsi la possibilité de suspension de ligne. Poliment, le Conseil rétorqua à ce propos :

Considérant qu’aux termes de l’article 11 de la Déclaration des droits de l’homme et du citoyen de 1789 : » La libre communication des pensées et des opinions est un des droits les plus précieux de l’homme : tout citoyen peut donc parler, écrire, imprimer librement, sauf à répondre de l’abus de cette liberté dans les cas déterminés par la loi » ; qu’en l’état actuel des moyens de communication et eu égard au développement généralisé des services de communication au public en ligne ainsi qu’à l’importance prise par ces services pour la participation à la vie démocratique et l’expression des idées et des opinions, ce droit implique la liberté d’accéder à ces services.

Internet ne devient pas une liberté fondamentale, mais le voici intimement lié à la liberté d’expression, ce qui le met sur un beau piédestal. Lors d’un jugement en vue d’une coupure de ligne, le juge devra statuer en connaissance de cause. Le Conseil rappelle aussi que « la liberté d’expression et de communication est d’autant plus précieuse que son exercice est une condition de la démocratie et l’une des garanties du respect des autres droits et libertés » ; et « que les atteintes portées à l’exercice de cette liberté doivent être nécessaires, adaptées et proportionnées à l’objectif poursuivi ».

A ce stade, la loi HADOPI était agonisante puisque sa colonne vertébrale (à savoir le concept de « riposte graduée ») est brisée. En effet au vue des conditions nécessaires, la coupure d’Internet ne sera pas mise en place (ou uniquement dans de très rares cas). Car personnellement, je n’ai jamais vu quelqu’un n’utilisait sa connexion Internet que pour télécharger illégalement… Et vous ?

Le Conseil porta finalement le coup de grâce. La loi HADOPI met en cause la responsabilité de l’abonné par la simple constatation du piratage, ce qui suffit à mettre en place le processus de coupure. C’est à l’abonné de démontrer que le piratage n’était pas de son fait mais dû à la fraude d’un tiers (l’installation du logiciel mouchard interdit de facto à l’abonné d’invoquer la fraude d’un tiers), des preuves impossibles à regrouper pour l’abonné. Cette méthode aboutit à faire de l’abonné mis en cause un coupable jusqu’à ce qu’il prouve son innocence. Ceci est conforme au code pénal… nord coréen, mais pas dans le code français. Le droit français prévoit même totalement l’inverse, quiconque est présumé innocent jusqu’à preuve du contraire.

Le Conseil constitutionnel tire d’ailleurs les conclusions de son annulation et de l’absence de jugeotte du parlement en donnant un mode d’emploi qui ne manque pas d’ironie. HADOPI existera bel et bien mais sera cantonnée à un travail d’avertissement sans frais (les mises en garde par courrier existent toujours, tout comme l’obligation de surveillance et de protection de sa ligne, mais elles ne peuvent aboutir à des sanctions prononcées par HADOPI), de filtrage et de préparation des dossiers pour l’autorité judiciaire, dans le but, et c’est là qu’on voit que le Conseil constitutionnel a le sens de l’humour, de limiter le nombre d’infractions dont l’autorité judiciaire sera saisie afin de ne pas saturer les tribunaux.

Une nouvelle loi, un nouvel échec, mais pourquoi ?

La loi HADOPI est en application depuis la mi-juin. Toutefois, celle-ci ne devrait pas changer grand chose aux habitudes des internautes (hormis l’obligation de sécuriser son réseau afin de se prémunir des avertissements d’HADOPI). Il convient donc de reconnaitre l’échec de ce texte. Et surtout de se poser la question du pourquoi.

Selon moi, la cause première de cet échec est la volonté d’établir une loi basée sur la répression. Depuis de nombreuses années les grandes majors se plaignent de la chute constante de leur chiffre d’affaires. Et depuis des années pour elles, le téléchargement illicite est le coupable désigné de cette baisse. Les études pour le prouver ce sont accumulées, tout comme les études pour prouver l’inverse. Ne faudrait-il pas se poser simplement la bonne question à savoir : Pourquoi le téléchargement illicite a-t-il un tel succès ? Sans rentrer dans un argumentation poussée, je pense que le téléchargement illicite sur internet a pu se développer parce qu’à une période il y avait une attente du public pour un consommation nouvelle et que les grands majors ont ignorés celle-ci pour d’autres projets (HD-DVD et BluerayDisc par exemple). Le public souhaitait (et souhaite encore) une alternative financièrement plus attractive que le commerce classique. Voilà ce sur quoi la loi aurait dû se construire, le renforcement au téléchargement légal et non sur la traque soutenue des pirates. Bien sûr une telle politique demanderait une effort conséquent sur les prix (pouvant même aller jusqu’à aligner leurs prix sur ceux des sites pirates) pour les grands majors. Un effort que les grands majors ne sont pas prêtes de faire à l’heure actuelle, préférant faire marcher la machine judiciaire dans des procès au-delà du réel (lisez ceci). Une guerre économique qui a encore de beaux jours devant elle…

Mais là n’est pas le seul point noir d’HADOPI. Selon la loi, les opérateurs de téléphonie ont l’obligation de maintenir l’accès aux services d’urgence. La mise en place des suspension d’accès à Internet nécessitera donc un temps d’adaptation pour les FAI, afin de séparer la téléphonie de l’offre Internet pour les offres triple play (Internet, Téléphone et Télévision). La possibilité d’astreindre à l’abonné l’installation par lui-même d’un logiciel pour suspendre l’accès Internet fut même proposé afin de minimiser le coût de mise en œuvre pour les FAI.

Par ailleurs la procédure d’identification de l’abonné pirate par l’intermédiaire de son identifiant IP est aussi critiquable. En effet l’IP n’est pas une plaque d’immatriculation que l’abonné porte obligatoirement sur lui a chaque visite sur la toile. Certains outils permettent de dissimuler son adresse IP de manière complètement légale, dans le jargon informatique on parle de proxy. Le principe est en effet relativement simple, au lieu de naviguer avec sa propre adresse IP, on passe par un proxy (un autre ordinateur) afin d’utiliser la sienne. Une méthode qui est de plus employée dans les nouveaux logiciels de téléchargement afin d' »anonymer » les transferts.

Des pirates hors d’atteintes

Voilà HADOPI est morte et les pirates vont pouvoir agir en toute inpunité…

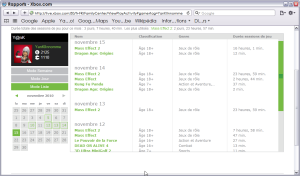

Que nenni, la justice n’a pas attendue HADOPI pour se mettre en marche et rappeler à la loi les brebis égarées dans la prairie des téléchargements illégaux. Pour preuve, ZataZ (journal informatique spécialisé) nous révélait le 4 juin dernier qu’un important portail privé d’échange Peer-to-Peer (SnowTigers) avait été contraint par la justice à la fermeture 24 heures auparavant (soit 12 jours avant l’entrée en vigueur de la loi HADOPI). SnowTigers avaient des serveurs basés aux Pays-bas et au Canada. Créé en novembre 2005, SnowTigers était classé comme étant le 1969ème site le plus visité du web d’après la société Netcraft. Fruit d’une enquête de deux ans, 21 serveurs furent saisies par les autorités et 10 personnes, dont l’administrateur du site, furent arrêtées. Mais l’affaire ne devrait pas en rester, puisqu’avec la saisie des serveurs l’ensemble des utilisateurs du site est susceptible d’être dans la ligne de mire des gendarmes. En effet sur les serveurs comme Snowtigers, Itoma, HDFrench et autres, la règle d’or est le partage et l’utilisateur ne jouant pas le jeu est très vite éjecter du site. Cela veut aussi dire que toutes les activités de chaque utilisateur sont archivées surveillées de très près par un tracker dans le but de tenir veiller au bon respect de la règle. Toutes ces données stockées sur les serveurs sont désormais dans les mains des autorités qui seront en faire bon usage. Selon certains les utilisateurs de portails torrents ne risquaient rien. Ces sites ne garderaient aucun logs, aucune trace des transactions, aucune trace des « dons ». La réalité est toute autre, chacun de ces sites établit des bases de données bien fournies de leurs utilisateurs (adresse IP, fichiers téléchargés, fichiers partagés…).

Moralité : Nul n’est intouchable.

Pour finir sur une pointe d’humour…

Voici l’alinéa de l’article L. 335-3 de la loi HADOPI :

« Est également un délit de contrefaçon toute captation totale ou partielle d’une œuvre cinématographique ou audiovisuelle en salle de spectacle cinématographique. »

Je vous invite donc à éteindre votre cerveau et à fermer les yeux lors de vos prochaines séances au cinéma, ceci bien sûr afin de respecter la loi.